DeepSeek开源FlashMLA,突破GPU算力瓶颈,加速AI行业发展

AI导读:

DeepSeek开源首个代码库FlashMLA,实现GPU算力突破,降低成本,加速AI行业发展。本周将继续开源四个代码库,业内期待其推动AI算法优化、模型轻量化等关键领域发展。

万众瞩目的Deepseek“开源周”,第一弹来了。

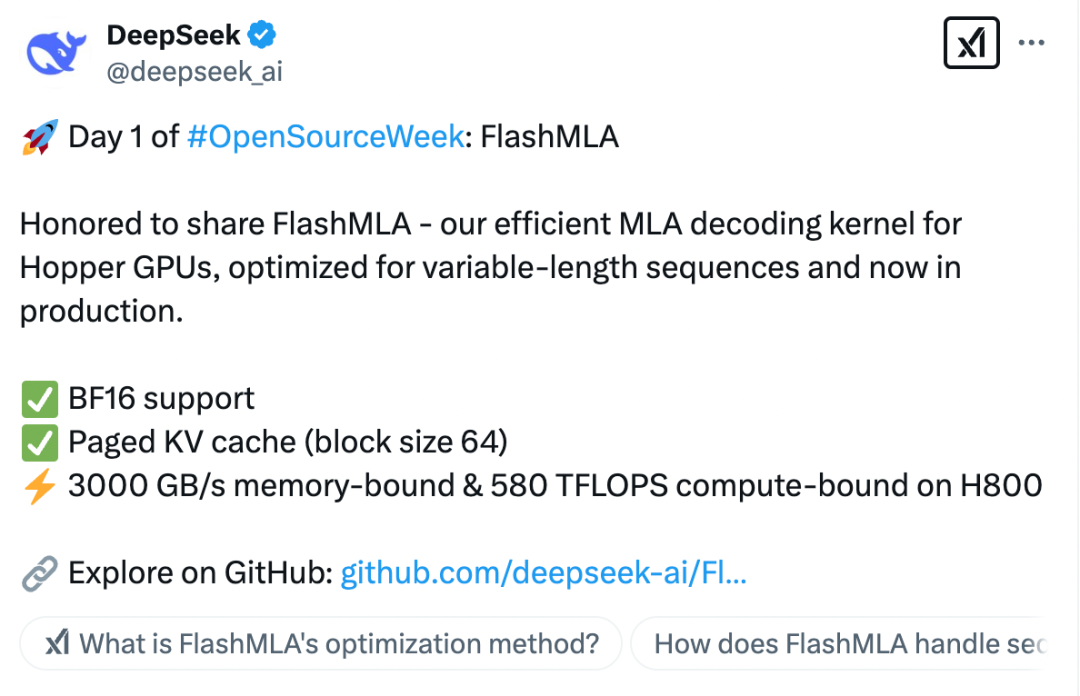

2月24日,DeepSeek开源了首个代码库FlashMLA。据了解,这是DeepSeek针对Hopper GPU优化的高效MLA(Multi-Head Latent Attention,多头潜在注意力)解码内核,专为处理可变长度序列而设计,现在已经投入生产使用。通过该内核,DeepSeek进一步突破GPU算力瓶颈。

上周四,DeepSeek宣布将在本周举办“开源周”活动,连续开源五个代码库,由此引燃了大家的期待。作为“开源周”的第一弹,FlashMLA给业界带来颇多惊喜。本周的剩下四个工作日,DeepSeek还将继续开源四个代码库。业内人士分析,其余四个代码库可能会与AI算法优化、模型轻量化、应用场景拓展等相关,涵盖多个关键领域。

根据DeepSeek的介绍,FlashMLA主要实现了以下的突破:

一是BF16支持,提供更高效的数值计算能力,减少计算精度损失,同时优化存储带宽使用率。

二是分页KV(Key-Value,一种缓存机制)缓存,采用高效的分块存储策略,减少长序列推理时的显存占用,提高缓存命中率,从而提升计算效率。

三是极致性能优化,在H800GPU上,FlashMLA通过优化访存和计算路径,达到了3000GB/s内存带宽和580TFLOPS的计算能力,最大化利用GPU资源,减少推理延迟。

简单理解,FlashMLA能够让大语言模型在H800这样的GPU上跑得更快、更高效,尤其适用于高性能AI任务,进一步突破GPU算力瓶颈,降低成本。

值得注意的是,DeepSeek之所以能够实现大模型训练与成本的大幅降低,与其提出的创新注意力架构MLA密不可分。MLA(多头潜在注意力机制)又被称为低秩注意力机制,是与传统的多头注意力机制(Multi-head Attention)不同的一种创新性注意力机制。

浙江大学计算机科学与技术学院和软件学院党委书记、人工智能研究所所长吴飞表示,我们理解一篇文章,更关切单词所刻画的主题概念,而非单词从头到尾的罗列等。传统大模型中的注意力机制由于需要记录每个单词在不同上下文中的左邻右舍,因此其变得庞大无比。DeepSeek引入低秩这一概念,对巨大的注意力机制矩阵进行了压缩,减少参与运算的参数数量,从而在保持模型性能的同时显著降低了计算和存储成本。

由于Flash MLA进一步突破了GPU算力瓶颈,英伟达股民对DeepSeek寄予厚望。

作为开源社区的“顶流”,DeepSeek以完全透明的方式与全球开发者社区分享最新的研究进展,加速行业发展进程。

在开源公告中,DeepSeek还表示,自己只是探索通用人工智能的小公司,作为开源社区的一部分,每分享一行代码,都会成为加速AI行业发展的集体动力。同时,DeepSeek称,没有高不可攀的象牙塔,只有纯粹的车库文化和社区驱动的创新。

DeepSeek的开源精神得到了网友的广泛赞誉。有网友表示,“OpenAI应该将它的域名捐给你”,还有网友猜测,“(开源周)第五天,我猜会是通用人工智能”。

据证券时报记者了解,(Open Source Initiative,开源代码促进会)专门针对AI提出了三种开源概念,分别是:开源AI系统、开源AI模型、开源AI权重。

业内普遍认为,DeepSeek的胜利是开源的胜利,开源大模型的创新模式为人工智能的发展开辟了新的路径。

民生证券研报认为,DeepSeek所有模型均为开源模型,这将加速AI应用的发展进程。当模型的成本越低,开源模型发展越好,模型的部署、使用的频率就会越高,使用量就会越大。

(文章来源:证券时报·e公司)

郑重声明:以上内容与本站立场无关。本站发布此内容的目的在于传播更多信息,本站对其观点、判断保持中立,不保证该内容(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关内容不对各位读者构成任何投资建议,据此操作,风险自担。股市有风险,投资需谨慎。如对该内容存在异议,或发现违法及不良信息,请发送邮件至yxiu_cn@foxmail.com,我们将安排核实处理。